یافتن URL های سایت: از اصول تا اجرا

آیا می دانید موتورهای جستجو چگونه میلیون ها صفحه وب را در کسری از ثانیه کشف و تحلیل می کنند؟ یا به عنوان مدیر سایت، چطور می توانید ساختار کامل محتوای خود را بررسی کنید؟ یافتن URL های سایت نه تنها برای سئو حیاتی است، بلکه ابزاری قدرتمند برای تحلیل محتوا، بهبود تجربه کاربری و حتی افزایش امنیت وب سایت محسوب می شود. در این مقاله اسپاد سرور، به زبانی ساده و کاربردی، مراحل کشف تمام لینک های موجود در یک دامنه را آموزش می دهیم.

شناخت انواع URL و مفاهیم پایه

دامنه چیست؟

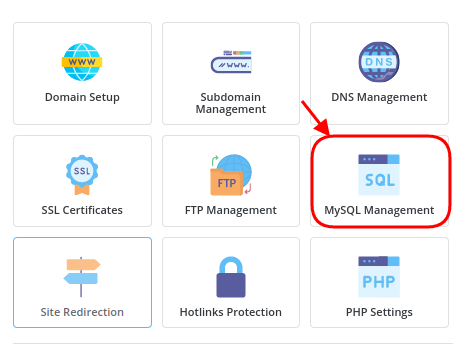

دامنه، آدرس اصلی وب سایت شماست (مانند example.com). این آدرس به عنوان شناسه منحصربه فرد سایت عمل می کند و زیر دامنه ها (مثل blog.example.com) بخش های مجزایی از محتوا را میزبانی می کنند. شما می توانید خرید هاست اقتصادی و دامنه و سرور مجازی را در اسپاد سرور با قیمت فوق العاده اقتصادی انجام دهید.

مقاله پیشنهادی: هاست، دامنه و سرور مجازی چیست؟ به زبان ساده

تفاوت URLهای داخلی و خارجی

URL داخلی: پیوندهایی که به صفحات همان دامنه اشاره می کنند.

مثال: https://example.com/contact-us

URL خارجی: لینک هایی که کاربر را به دامنه های دیگر هدایت می کنند.

مثال: https://external-site.com/resources

URL مطلق در مقابل نسبی

مطلق: آدرس کامل شامل پروتکل، دامنه و مسیر. مثال: https://example.com/about

نسبی: تنها بخشی از آدرس که نسبت به صفحه فعلی تفسیر می شود. مثال: /about یا images/logo.png

اگر نیاز به راهنمایی برای خرید هاست اقتصادی و دامنه و سرور مجازی دارید، متخصصان با تجربه اسپاد سرور آماده خدمت به شما هستند. برای تماس با ما، روی “تماس با اسپاد سرور” کلیک کنید.

روش های یافتن URL های سایت

چرا باید تمام URLهای دامنه را پیدا کنیم؟

پافتن تمام لینک های وبسایت برای بهینه سازی سئو، شناسایی لینک های شکسته، محتوای تکراری و فرصت های لینک سازی ضروری است. همچنین می تواند به ممیزی محتوا، بررسی سازماندهی اطلاعات و بهبود ناوبری سایت کمک کند. از نظر امنیتی نیز، کشف صفحات قدیمی یا آسیب پذیری های احتمالی اهمیت دارد.

روش اول: استفاده از ابزارهای بدون کد برای یافتن URL های سایت

ابزارهایی مانند Screaming Frog یا Sitebulb به سادگی با وارد کردن دامنه انجام می دهند. این ابزارها گزارش های جامعی از ساختار سایت ارائه می دهند و برای مبتدیان ایده آل هستند.

روش دوم: خزیدن با پایتون (کدنویسی) برای یافتن URL های سایت

با استفاده از کتابخانه های httpx و BeautifulSoup، می توانید یک خزنده ساده بسازید:

python

import httpx

from bs4 import BeautifulSoup

from urllib.parse import urljoin

async def crawl_page(url):

async with httpx.AsyncClient() as client:

response = await client.get(url)

soup = BeautifulSoup(response.text, ‘html.parser’)

links = [urljoin(url, a[‘href’]) for a in soup.find_all(‘a’, href=True)]

return links

این کد ابتدا صفحه هدف را دریافت کرده و تمام لینک های موجود را جمع آوری می کند. برای جلوگیری از مسدود شدن، تنظیماتی مانند تأخیر بین درخواست ها و استفاده از پروکسی توصیه می شود.

روش سوم: استفاده از فریم ورک Scrapy

Scrapy یک چارچوب قدرتمند برای خزیدن حرفه ای و <strong>پیدا کردن URL </strong>های سایت</strong> است:

python

class DomainSpider(scrapy.Spider):

name = “domain_crawler”

start_urls = [‘https://example.com’]

def parse(self, response):

for link in response.css(‘a::attr(href)’).getall():

yield {‘url’: response.urljoin(link)}

yield from response.follow_all(css=’a’, callback=self.parse)

چالش های پیشرو و راه حل ها

- مسدود شدن توسط سرور هنگام پیدا کردن تمام URL های سایت: راه حل: استفاده از پروکسی های چرخشی و تغییر User-Agent.

- صفحات پویا با جاوا اسکریپت: راه حل: بهره گیری از ابزارهایی مانند Selenium یا Puppeteer برای رندر صفحات.

- محدودیت نرخ درخواست (Rate Limiting): راه حل: افزودن تأخیر تصادفی بین درخواست ها با استفاده از time.sleep(random.randint(1,3)).

- تشخیص CAPTCHA: راه حل: استفاده از سرویس های حل CAPTCHA مانند 2Captcha یا Anti-Captcha.

سؤالات متداول یافتن URL های سایت

آیا خزیدن وب سایت ها قانونی است؟

بله، تا زمانی که به قوانین robots.txt احترام بگذارید و از داده ها سوءاستفاده نکنید، این کار مجاز است.

بهترین ابزار برای شروع چیست؟

برای مبتدیان، Screaming Frog یا Scrapy جهت یافتن URL های سایت پیشنهاد می شود. توسعه دهندگان حرفه ای می توانند از ترکیب پایتون و Selenium استفاده کنند.

جمع بندی نهایی

یافتن URL های سایت فرایندی است که به دانش فنی، انتخاب ابزار مناسب و مدیریت چالش ها نیاز دارد. چه از روش های بدون کد استفاده کنید و چه به سراغ کدنویسی بروید، هدف نهایی دستیابی به نقشه کامل سایت برای بهبود سئو، امنیت و تجربه کاربری است. به خاطر داشته باشید: همیشه اصول اخلاقی را رعایت کنید و به حریم خصوصی وب سایت ها احترام بگذارید.

با به کارگیری تکنیک های این مقاله، نه تنها ساختار سایت خود را بهینه می کنید، بلکه گامی بلند در جهت حرفه ای شدن در دنیای وبمستری برمی دارید!